Nuestro proyecto combina técnicas de bioacústica, procesamiento de señales y machine learning para estudiar los ultrasonidos emitidos por plantas en condiciones controladas. A continuación, detallamos el proceso paso a paso:

1. Configuración del experimento

-

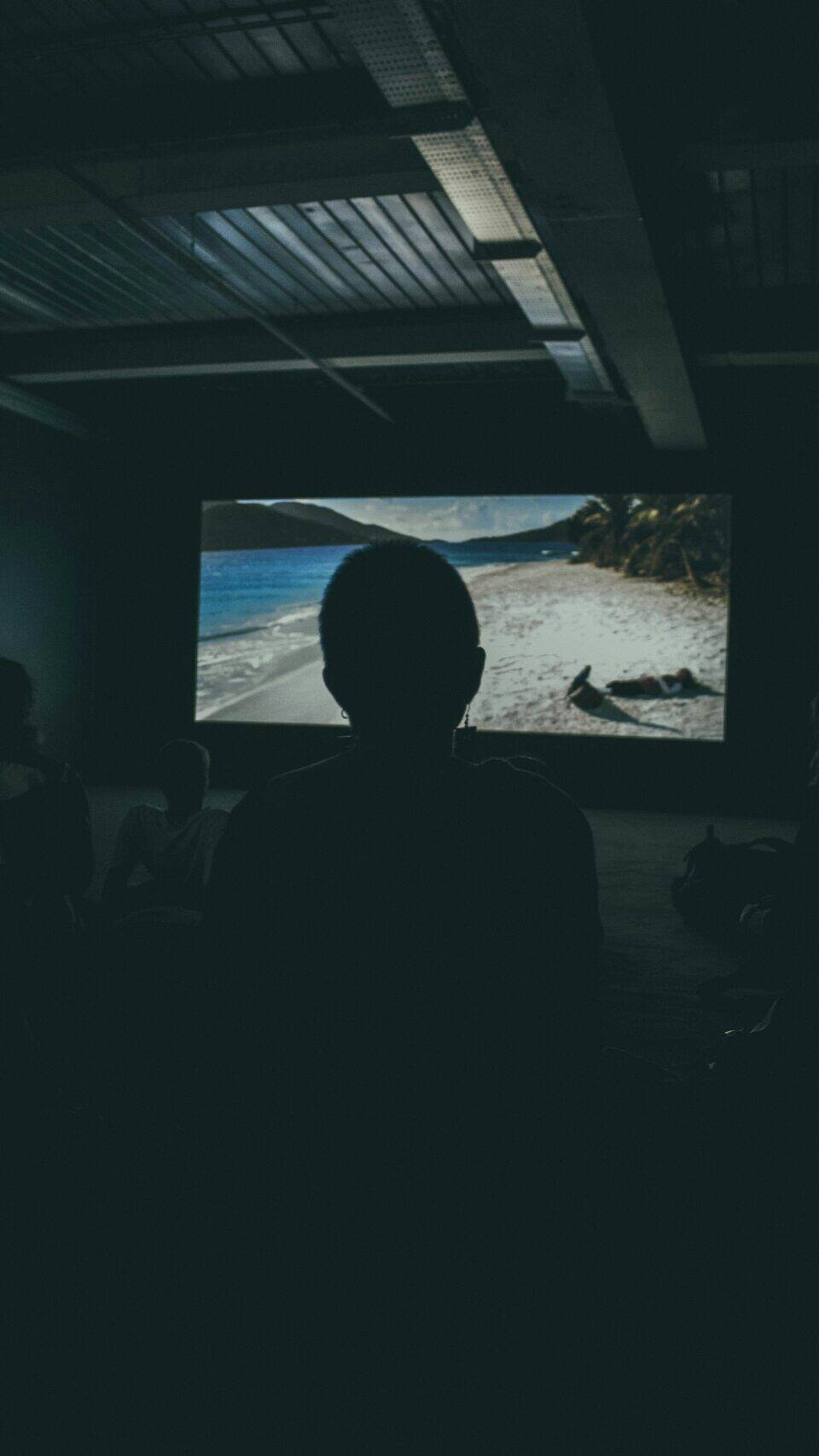

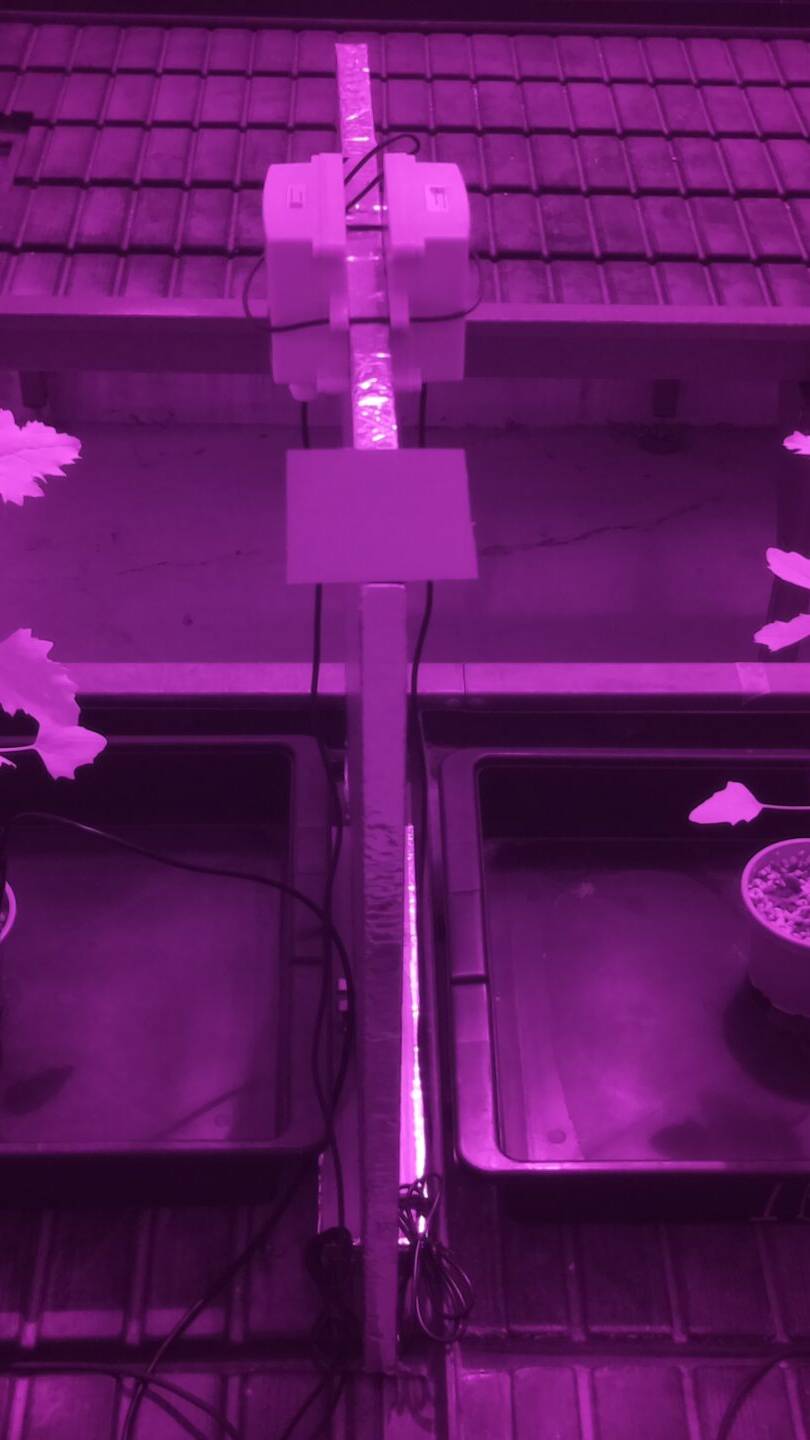

Set de grabación: Trabajamos en una cabina aislada dentro del invernadero del IBMCP, donde registramos simultáneamente cuatro plantas equipadas con micrófonos especializados en ultrasonidos (frecuencias >20 kHz).

-

Aislamiento acústico: Cada planta está separada por bandejas que evitan interferencias entre los micrófonos, ya que los ultrasonidos vegetales son demasiado débiles para atravesar obstáculos.

2. Captura y procesamiento de señales

-

Detección en tiempo real: Un conversor analógico-digital (A/D) graba continuamente el audio, pero solo guarda fragmentos cuando detecta un ultrasonido, registrando la hora exacta del evento.

-

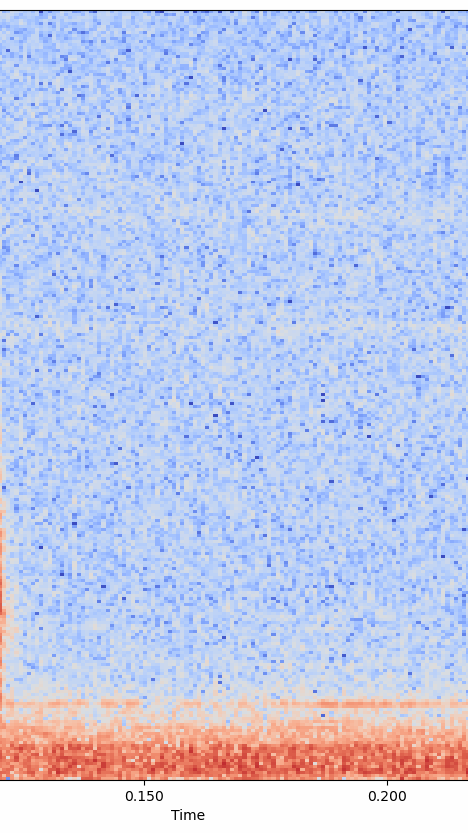

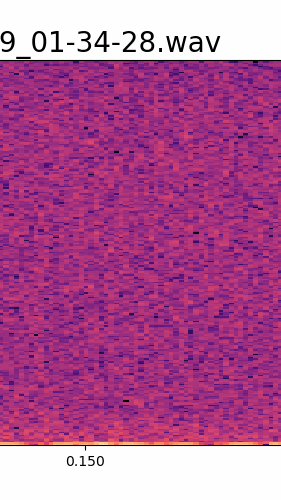

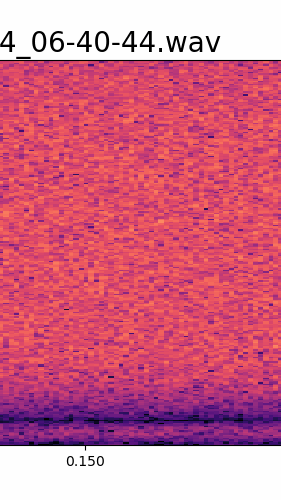

Filtrado de ruido: Mediante técnicas de Digital Signal Processing (DSP) en Python, aislamos los ultrasonidos de las plantas eliminando sonidos ambientales (como herramientas o equipos eléctricos). Para ello, aplicamos la Transformada de Fourier, que descompone las ondas sonoras complejas en sus frecuencias puras, representadas en espectrogramas.

3. Validación de los datos

-

Detección cruzada: Cuando un micrófono capta un ultrasonido, el sistema guarda simultáneamente las grabaciones de los cuatro micrófonos. Esto nos permite discriminar el origen del sonido:

-

Si los cuatro micrófonos registran el mismo ultrasonido, lo atribuimos a fuentes ambientales y descartamos la muestra.

-

Si solo un micrófono detecta el ultrasonido, confirmamos que proviene de la planta asociada y la marcamos como válida.

-

4. Metadatos y análisis posterior

Cada ultrasonido válido se vincula a metadatos ambientales (temperatura, humedad, luminosidad, etc.) capturados por sensores en tiempo real. Estos datos se envían al equipo del VRAIN, donde se emplean algoritmos de machine learning para:

-

Identificar patrones entre los ultrasonidos y variables como especie, edad o condiciones ambientales.

-

Desarrollar un modelo predictivo de la "voz" de las plantas.

Visualización de resultados

Los espectrogramas nos permiten "ver" los ultrasonidos: en ellos, el eje horizontal representa el tiempo, el vertical la frecuencia, y la intensidad se codifica en colores (azul = bajo, rojo = alto). Así, diferenciamos claramente los ultrasonidos vegetales (picos sobre 20 kHz) del ruido ambiental.

5. Arte y ciencia: una colaboración transversalFinalmente, el Colectivo Estampa (Barcelona) transformará los datos científicos —ultrasonidos y metadatos— en una base de datos accesible y una instalación audiovisual inmersiva. Su participación no se limita a la fase final, sino que es parte activa desde el diseño del experimento, enriqueciendo el proceso con perspectivas artísticas. Esta simbiosis entre arte y ciencia, clave en nuestro enfoque, refleja el compromiso del IBMCP con la innovación a través de la hibridación de saberes: la creatividad como metodología y la tecnología como lenguaje común.